备课资料

AI将如何发展:“神”、“神经”和“神经病”

录入者:15959541500 人气指数:次 发布时间:2020年11月12日

出品| 新浪科技《科学大家》、造就

撰文| 邬学宁 复旦大学客座教授,数据科学50人成员

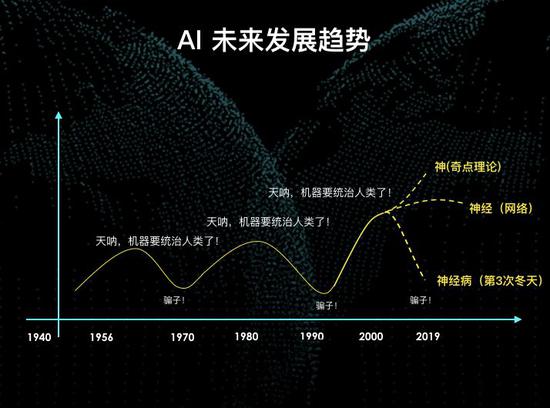

自达特茅斯会议诞生以来,人工智能已经走过60年的历史。在过去60年中,人工智能经历了两次繁荣和低谷,现在正处于第三次繁荣期,关于未来的人工智能的走向,有三种观点。

第一种观点以《未来简史》的作者尤瓦尔·赫拉利、谷歌工程总监未来学家雷·库兹维尔和软银的创始人孙正义等人为代表,他们认为未来的人工智能是神,是上帝。

比如孙正义认为30年后,人工智能的智商是一万,而爱因斯坦的智商不过两百,人工智能看人类如同现在人类看蚂蚁。

第二种观点认为,本轮人工智能的主要推动力是神经网络。神经网络以大数据作为燃料,以强大的计算力作为引擎,但是当下大数据的红利正逐渐消失,主宰了芯片处理能力的摩尔定律经过60年的指数增长,也已逼近了理论极限得天花板。这一派认为未来人工智能会缓慢向前发展,但是速度不会像前两年这么快,我以“神经”来作为这派的核心词。

第三种观点认为历史还将重演,人工智能的冬天还会再来,他们认为“人工智能统治人类”如同神经病一样荒唐可笑。

这三派的核心观点,简而言之,可以用“神”、“神经”和“神经病”三个词来归纳。

这一轮的人工智能热潮是怎么开始的?

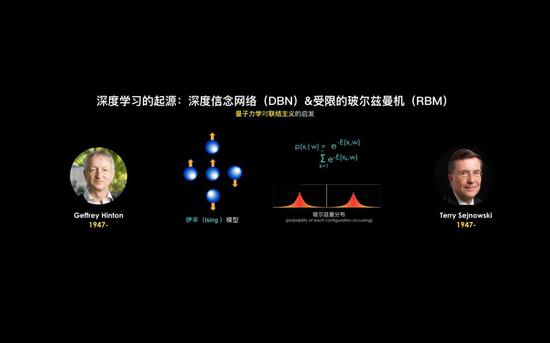

本轮AI发端于2006年,多伦多大学教授杰弗里·辛顿(Geoffrey Hinton)等人彼时连发了三篇关于深度学习的重量级论文,提出了深度信念网络。

虽然该网络目前应用已不是很多,但在当时却是如冬日惊雷打破了神经网络联结主义长达十年的沉寂,开启了神经网络的新纪元——深度学习,该网络采用了逐层贪心训练的方法,对算力的要求较低。

深度信念网络是将受限的玻尔兹曼机一层层堆叠而成,而玻尔兹曼机是在上世纪80年代由辛顿与特伦斯(Terrence Sejnowski)一起发明的。

AlphaGo是从哪里来的?

2016年,AlphaGo以4:1战胜了韩国著名棋手拥有16个世界冠军头衔的韩国超一流棋手李世乭九段,引起了媒体和大众对人工智能的极大关注。

这几乎是人工智能最火爆的一次亮相,但少有人知道,AlphaGo是从哪里来的?

AlphaGo的起步于Atari--一个古老的80年代的电视机游戏,2012年,Deepmind用摄像头对准电视机,让人工智能玩Atari,通过计算机视觉和强化学习让机器学习控制这个游戏,尽量得到更多的分数,只要将球反弹到上面消除彩色砖块就能得分获得“奖励”(Reward)。

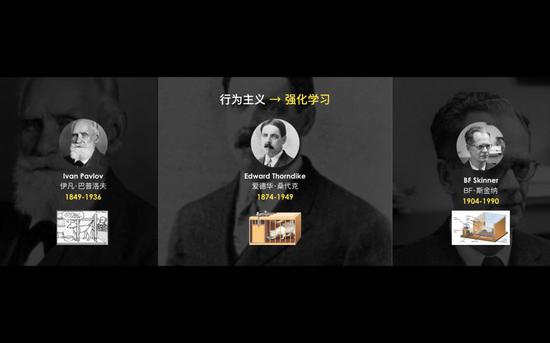

这个训练过程和心理学的行为主义的思想是一致的,训练AI就像训练一只小狗,做对了就给它吃颗糖。

在训练了四个小时之后,AI已经发现了一个打赢游戏的秘诀——将左边砖块打穿,然后球在上面空间反复来回弹射,可以自动消除大量砖块,快速得分。

这个“秘诀”是设计这个AI程序的的工程师也不曾知道的,这也就可以解释为什么AlphaGo在打败柯洁和李世乭的时候,使用了很多人类从未见过的招数。

行为主义作为心理学的一个学派,他们认为思维不可被观察,不适合作为科学的研究对象,行为才是合适的研究目标。

在人工智能中,行为主义对应为强化学习。

大家都知道“巴甫洛夫的狗”这个实验,有没有听说过知道“桑代克的猫”呢?在“巴普洛夫的狗”这个实验当中,狗是完全被动的受测对象,只是听到铃声流口水,没有任何选择的机会。而桑代克给了猫一个选择:猫被关在一个笼子里,笼子里有个开关,一旦被猫按下后,门就会打开。第一次猫被关进笼子,要花很久才能够按动开关,逃出笼子,第二次被放进去之后,猫会直接按动开关,逃出生天。

第三位行为主义的大师是斯金纳,斯金纳给测试对象2个选择,他把一只老鼠放在笼子里,笼子里有两个按钮,按下其中一个按钮,食物会掉落下来,按下另一个按钮,则会警报声大作,把老鼠吓坏了。被警报声惊吓过的老鼠被再次放进笼子后,它会远远的躲开电铃的开关。

行为主义认为:我们无法通过语言来了解一个人真正在想什么,只有行为才可以被客观的观察和研究。相对应的,人工智能领域持相似观点的学者,并不关心AI是怎么想的,只关心AI是怎么做的。

人工智能已开始理解我们的语言,甚至拥有了“想象力”?

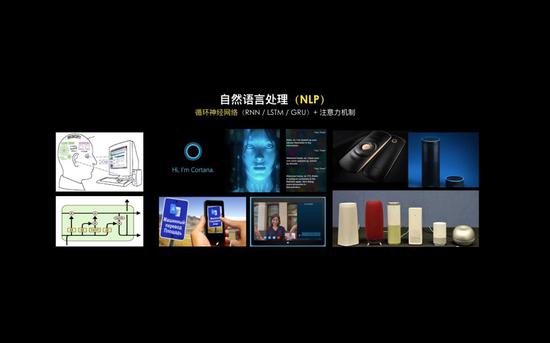

在地球上,有很多动物的视觉超越人类,但是,能使用语言进行沟通却只有人类,人类的自然语言被称为人工智能王冠上明珠,至今尚未被完全攻克。

短时记忆位于大脑前额叶的部分,也称工作记忆,而长期记忆则存储在脑后的位置,当我们理解了一个概念后,就会从工作记忆转存到长期记忆。

深度学习在处理自然语言和其他时序相关的数据时,经常使用一种名为长短时记忆(LSTM)的算法。

这两年我们看到各种机器翻译、个人助手和智能音箱等各种AI商业化应用层出不穷,其主要原因是因为深度学习在语音识别领域取得了突破,使得AI开始可以理解我们在说什么,从而打开了自然语言处理的大门,LSTM被广泛应用于自然语言处理和其他时序相关的场景。

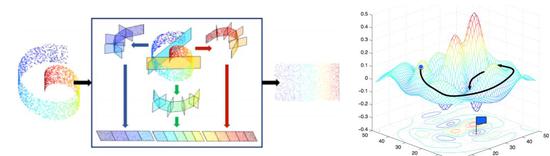

和辛顿一起获得图灵奖的卷积神经网络(CNN)之父杨力昆(Yann LeCun)曾说过,在过去的十年中,人工智能领域最有趣的想法要数生成对抗网络(GANs)了。

GANs使AI具有“想象力”,上图中GANs把川普与尼古拉斯·凯奇的照片进行合成,类似用GANs来生成图片的应用层出不穷,甚至,LinkedIn上已经出现了虚拟的间谍,通过GANs“想象”出来的可以乱真的但实际并不存在的脸,真人间谍操控这个虚拟的美女,在社交媒体上与美国的一些高官攀关系并窃取有价值的情报。

最近也有一些关于GANs负面消息,比如Deepnude等。 GANs的核心思想是引入了博弈论,让用两个神经网络互相博弈,一个网络负责造假,另一个负责鉴定真假,两个网络互相对抗博弈,造假和鉴定真假的水平都不断上升,最终达到纳什均衡,然后就可以把判定真假的网络扔掉,因为造假的网络已经完全可以以假乱真了。

GANs的成功表明:“对抗”是实现智能的一个途径,AlphaGo也利用是对抗博弈使其达到很高的水准。

人工智能一直在吃20年前的老本么?

不论是卷积神经网络,还是LSTM等循环神经网络,都是在上世纪90年代就已经提出。由于受当时的算力和数据量的限制,在当时都没有走红,而是在20年之后才爆发。

现在的人工智能产业看上去非常的繁荣,但理论层面缺乏创新的思想突破,还在吃20年前的老本。

未来五年到十年,深度学习、人工智能领域出现重大的突破的概率并不太高,但这并不妨碍工业界大量AI应用落地。

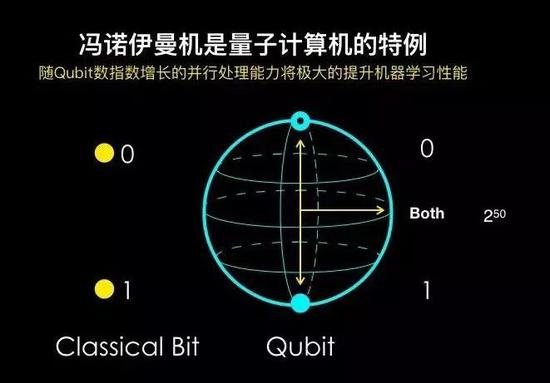

算力是本轮AI繁荣的三个要素之一,具有多核并行处理能力的GPU已成为深度。随着量子计算的发展,量子计算机未来也可能对AI产生深远的影响。

我们目前使用的计算机被称为经典计算机,也称冯诺依曼机,内部以0和1来表达世界。

对于量子计算机而言,一个Qubit(量子位)可以用a和b两个(复)数表达0和1两个数字的叠加态,也就是拥有了2个信息位(2的1次方);两个Qubit,可以表达2的2次方个信息位的信息。

一个50 Qubit量子计算机的强大并行处理能力所产生的算力将超过目前世界上任何一台超级计算机。

经典计算机可以被视为量子计算机的特殊情况(类似于三角函数取0度或90度的特殊情况),恰似逻辑推理是概率的特殊情况(概率为0或1)。

展望未来10-20年,一旦量子计算机实现了稳定计算能力,必将对人工智能产生一个颠覆性的影响,对电子商务和加密货币的影响也将是翻天覆地的。

但目前,人工智能并没有我们人类意义上的“智能”,只是在做数学上最小化。

绝大部分担心AI威胁人类的人,包括刚去世不久的黑洞物理学家霍金和特斯拉汽车的CEO伊隆·马斯克,都提出人工智能对人类的“威胁论”,他们几乎都没有人工智能的落地经验,因为不了解导致了恐惧和担忧。

人工智能的一线研究人员几乎没有人持类似观点,正如前百度首席科学家吴恩达所言,现在担心人工智能统治人类,无异于担心火星上人口过剩。

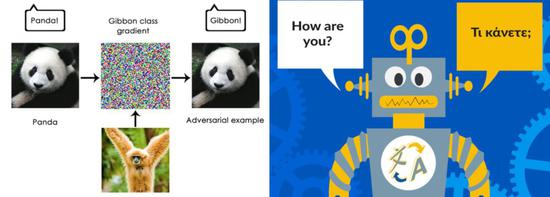

深度学习建立了从输入到输出的一个自动映射的过程,在部分应用中表现得非常完美,然而,这并不代表AI具有人类的智能,甚至还想差很远。

AlphaGo虽然能打败柯洁、李世乭,但是它并没有意识,它并不知道自己在下围棋;同样的,人工智能翻译翻得再好,它也不能完全替代专业的人类翻译。因为它也并不理解它翻译的内容,虽然它让你感觉到它翻译的很完美,属于典型的“以其昏昏,使人昭昭”。

上面提到的讲对抗生成网络,也会犯一些人类绝对不可能犯得错误。

上图左侧人工智能正确地识别出一只大熊猫,我们一个长臂猿的梯度数据作为一个随机噪音,混入熊猫的照片数据中,AI就把大熊猫误认为了长臂猿,这对人来说是绝对不可能发生的错误。

目前,深度学习最大的问题之一就是它是个“黑盒子”,我们并不理解里边的每个神经元所代表的含义。

已经有科学家,在这方面进行了一些探索性研究,并在计算机视觉领域,部分的解决了神经元问题。

比如,对于脑科学家长久以来争论不休的“祖母细胞”的问题,麻省理工大学的研究人员发现,用人工神经网络验证了真的可能是对于一个重要概念,大脑会分配一个或相关一组细胞来表示这个概念,每当这个概念被提起时,相关的细胞就会被激发。

以后最浪漫的情话可能是:“我为你单独分配了一个神经细胞”。

我们看到,不仅脑科学可以促进人工智能的发展,反过来人工智能也能够促进脑科学的研究,昔日两个大相径庭的领域正越走越近,相互融合。

深度学习另外一个局限性就是需要大量的人工的标签,无人驾驶公司雇佣的打标签的人工成本,甚至超过了数据科学家的成本。从这个角度,目前监督式机器学习的情况可以说是:“有多少人工,就有多少智能”。

如果我们把机器学习中主要的方法和大脑做一个对比的话,监督式学习,依靠人类打标签的,也就是说有标准答案的,对应为人类小脑的机制。对这种机器学习,我们已经研究的比较成熟了。 但问题在于,互联网上大量的数据是没有标签的,依靠人去打标签的成本太高而不现实。

这类非监督的机器学习方法可以很好的去发现数据本身的特征与结构,与监督式学习一起工作,可以得到更好的效果。大脑皮层的功能对应的就是非监督机器学习。

AlphaGo对应的强化学习介于上述两者之间,强化学习是没有一个明确的,打标签的这样一个动作,但是它会得到一个环境的反馈。

这种学习方式比监督式学习通用性强很多,它不需要标签数据,只通过一个回报的数值来改进模型,通用性强,也是未来实现通用人工智能(AGI)的重要路径。

未来的机器的发展可能是以强化学习和非监督学习为主,而一些深度学习模型中已经融入了非监督机器学习,而AlphaGo则是强化学习和深度学习相结合的产物。

强化学习对应的大脑结构是基底神经节。

做乌鸦,不要做鹦鹉

人工智能在过去两次热潮当中,都是以逻辑推理为核心的符号主义所主导的,这一脉可以上溯到亚里士多德和苏格拉底。某些做知识图谱的人工智能的公司,会去招哲学博士,为什么?

因为,两千年前的亚里士多德的本体论在今天构建知识图谱的过程中,其思想仍然是核心。

知识图谱被认为是下一代的搜索引擎,你可以在百度上输入一个问题:姚明的妻子是谁?百度会直接告诉你答案:叶莉,这是因为知识图谱是基于逻辑推理的。

在金融行业,知识图谱有非常广泛的应用于风控,它有助于明显提高风控的表现,如果逾期率的风险能降低0.1%,对于很多企业来说,每年都能减少了上亿的损失。

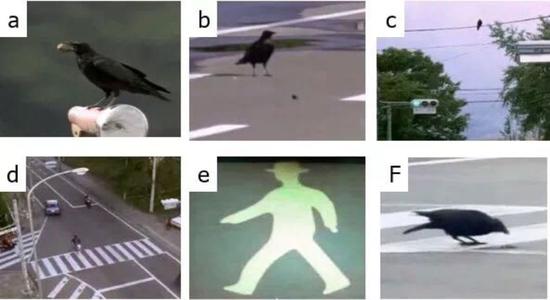

和机器学习所代表的概率性思维不同,知识图谱所代表的,是另一种思维——确定性的逻辑推理。这两种思维的结合会产生很好的效果。 现在的人工智能被称为窄人工智能(ANI)。就像一只鹦鹉,学人说话学得很像,但它的智力其实很低。我们将来要实现的人工智能可能是乌鸦,在日本有人拍到的一段画面:

乌鸦捡到了一个坚果,但这个坚果很硬,它吃不到里边的肉,乌鸦就把坚果抛向高空掉在地上,还是砸不碎坚果。于是这只乌鸦把坚果放在马路当中,希望来往的车辆把坚果轧碎。但路上车水马龙,乌鸦去吃的时候不小心被车轧死怎么办?乌鸦又发现了红绿灯,当红灯亮的时候,车会停下来,这时候下去吃坚果是最安全的。

未来,我们要做的人工智能应该是乌鸦,而不是鹦鹉。

深度学习基本解决了感知的问题,但是要解决问题,必须要理解问题,从把问题抽象出来并形成概念,然后加上逻辑推理,现在,在抽象、形成概念和理解问题的这些环节还比较薄弱的,也是未来潜力巨大的领域。

群体智能

有很多实现未来人工智能的路径,其中有一种是我个人特别感兴趣的——群体智能。

我们看到不管是鸟群还是蚂蚁,蜜蜂还是萤火虫,它们单体的智商,都非常低。但是,当它们聚集在一起的时候,没有一个个体控制群体,群体作为一个整体,却涌现出一种非常高超的,一个具有生命的智能。

我们大脑当中的神经网络也是类似的,每个神经元的功能都非常简单,但是,大脑860亿个神经元,它们在一起由量变到质变,产生非常高级的智能。

最后我想用费米的一句话,来结束本文, “宇宙看上去包罗万物,但其实并不那么复杂,它只是由数量众多的,非常简单的结构组成。”

这轮人工智能从脑科学、心理学、 经济学,甚至量子力学中都获取了灵感。未来的人工智能,将从哪里获取灵感呢?

- 上一篇:宇宙为何会膨胀?这让爱因斯坦非常“懊恼”!

- 下一篇:人工智能将如何服务医疗行业